中国的人工智能硬件开发商在自主研发加速器方面进展迅速。然而,中国最先进的人工智能开发商日益认识到,国内硬件在短期内不太可能赶上美国领先企业,这极大地限制了具有竞争力模型的开发。为此,为了保持与美国同行的竞争力,据《华尔街日报》报道,中国的人工智能开发商正在探索在云端租用英伟达即将推出的鲁宾(Rubin)GPU的方法。

当英伟达于1月推出其面向人工智能的鲁宾数据中心平台时,它公开点名了美国客户,而省略了中国客户。该公司在最近几个季度一直采取这种做法,这反映了美国的出口规则、其遵守这些规则的承诺,以及其不向投资者暗示中国市场开放的意图。中国企业接收到了这一信息,并开始探索远程获取英伟达尖端处理器的方法,以避免落后于美国竞争对手。

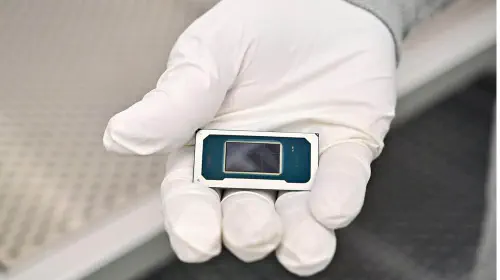

报道称,中国的人工智能公司已开始谈判,希望获取位于中国境外数据中心(特别是在东南亚和中东地区)托管的NVL144 GR200及其他基于英伟达鲁宾架构的系统。直到本周中期,这些安排通常被认为是合法的。然而,它们在设计上存在限制:计算资源是租用而非拥有,容量是共享而非专用,并且在最坏的情况下,部署时间表取决于第三方运营商而非内部计划。

使用远程硬件训练前沿人工智能模型存在困难并不令人意外,因为在远程云数据中心租用鲁宾与本地部署之间存在巨大差异。美国的超大规模云服务商可以大规模集成鲁宾加速器,围绕新硬件紧密调整其软件栈,并为长期训练任务预留庞大的GPU集群。相比之下,计划租用鲁宾算力的中国开发商将不得不应对有限的分配额度、跨境延迟、有限的系统定制自由,在某些情况下还需要排队等待。如果他们租用到足够的系统——目前美国有云数据中心运行着数十万个布莱克威尔(Blackwell)GPU——他们或许能够相对顺利地训练模型。然而,如果他们无法及时找到合适的云服务,每个项目将拥有更少的人工智能加速器,并且在某些情况下将无法运行大型训练任务,这将直接限制模型规模、实验节奏和迭代速度。

与此同时,对于曾使用由A100、H100、H800和H20等不同英伟达GPU组成的集群来训练其前沿模型的中国开发商来说,复杂的训练过程和效率低下是众所周知的。由于他们无法正式采购布莱克威尔,他们也曾在云端租用,据《华尔街日报》报道,内部人士表示这种体验成本高昂且操作不便。因此,他们已经知道如何应对效率低下的问题。

随着下一代前沿模型和鲁宾GPU的出现,情况将变得更加复杂。随着模型规模的扩大,不间断访问大型、同构GPU集群的价值日益增长,而租用的算力很少能提供这种条件。即使交易能够达成(考虑到对云访问的新限制,这并非保证),这通常也会使中国开发商相对于资金雄厚的美国竞争对手处于结构性劣势,后者可以在同一屋檐下部署数以万计的加速器。

还存在另一个复杂因素。瑞银(UBS)估计,中国的超大规模云服务商去年在资本支出上花费了约570亿美元,这大约是美国同行的十分之一。为了更直观地理解这个数字,这低于Meta公司去年超过700亿美元的资本支出。考虑到财务限制,中国的人工智能开发商是否能够或多或少地保持与美国同行的竞争力,仍有待观察。