随着人工智能GPU集群规模不断扩大,其跨集群通信的极端需求正推动光通信技术在网络层级的应用。今年初,英伟达宣布其下一代机架级人工智能平台将采用硅光子技术与共封装光学(CPO)互连方案,以实现更高传输速率和更低功耗。在本年度Hot Chips大会上,该公司进一步披露了下一代Quantum-X和Spectrum-X光子互连解决方案的技术细节,并确认将于2026年正式推出。

英伟达的技术路线很可能紧密跟随台积电的COUPE技术蓝图,该规划分为三个阶段实施:第一代面向OSFP连接器的光引擎可实现1.6 Tb/s数据传输并降低功耗;第二代采用CoWoS封装与共封装光学技术,在主板层级实现6.4 Tb/s传输能力;第三代目标是在处理器封装内实现12.8 Tb/s速率,并进一步降低功耗与延迟。

为何需要CPO技术?

在大型人工智能集群中,数千个GPU需要作为统一系统运作,这对处理器互连架构提出严峻挑战。新型网络架构将Tier-1(架顶)交换机从每个机架移至整排机架末端,通过跨机架的低延迟架构实现统一管理。这种布局使得服务器与首层交换机之间的距离大幅延长,铜缆在800 Gb/s速率下已不适用,几乎所有服务器-交换机及交换机-交换机链路都需采用光连接。

传统可插拔光模块在此环境下存在明显局限:数据信号需离开ASIC芯片,穿越主板和连接器后方进行光电转换。据英伟达测算,这种方法会导致高达22分贝的电信号损耗(在200 Gb/s通道上),需通过复杂处理进行补偿,使单端口功耗增至30W——这不仅需要额外冷却系统,还增加了故障风险,随着人工智能部署规模扩大,该问题将变得难以承受。

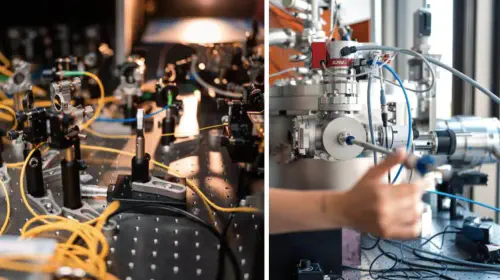

CPO技术通过将光转换引擎与交换机ASIC协同封装,使信号几乎立即耦合至光纤,避免了长距离电信号传输。由此将电信号损耗降至4分贝,单端口功耗减少至9W。这种设计不仅移除了多个潜在故障点,还极大简化了光互连的实施流程。

英伟达宣称,通过摒弃传统可插拔收发器并将光引擎直接集成至交换机芯片(依托台积电COUPE平台),其在效率、可靠性和可扩展性方面获得显著提升:能效提高3.5倍,信号完整性增强64倍,因有源器件减少使可靠性提升10倍,且更简化的服务与组装流程使部署速度加快约30%。

以太网与InfiniBand的CPO解决方案

英伟达将为以太网和InfiniBand技术双双引入基于CPO的光互连平台。计划于2026年初率先推出Quantum-X InfiniBand交换机,每台交换机提供115 Tb/s吞吐量,支持144个800 Gb/s端口。该系统集成具备14.4 TFLOPS网络处理能力的ASIC,支持第四代可扩展分层聚合缩减协议(SHARP)以降低集体操作延迟,并采用液冷散热。

同年下半年,英伟达将通过Spectrum-X Photonics平台把CPO技术引入以太网。该平台基于Spectrum-6 ASIC芯片,推出两款设备:SN6810提供102.4 Tb/s带宽(128个800 Gb/s端口),大型号SN6800则扩展至409.6 Tb/s带宽(512个800 Gb/s端口),两者均采用液冷方案。

英伟达预计其基于CPO的交换机将为日益复杂的大型生成式人工智能集群提供动力。通过采用该技术,此类集群可消除数千个独立组件,实现更快速的安装、更简便的维护以及更低的单连接功耗。因此,采用Quantum-X InfiniBand和Spectrum-X Photonics的集群在启动时间、首令牌生成时间和长期可靠性等指标上均有显著改善。

英伟达强调,共封装光学并非可选升级,而是未来人工智能数据中心的结构性需求。这表明该公司将其光互连技术定位为相对于竞争对手(如AMD)机架级人工智能解决方案的关键优势——这也正是AMD收购Enosemi的核心动因。

技术演进路径

值得关注的是,英伟达的硅光子技术演进与台积电COUPE(紧凑通用光子引擎)平台发展紧密协同。该平台通过堆叠65纳米电子集成电路(EIC)与光子集成电路(PIC),采用SoIC-X封装技术构建第一代COUPE。其技术路线分为三阶段推进,最终目标是在处理器封装内实现12.8 Tb/s传输速率,并持续优化功耗与延迟性能。