所有学习第二语言的人都会告诉你,习语往往是块绊脚石。就拿我的母语英式英语来说——“倾盆大雨”“像引擎盖一样紧贴不放”“鲍勃是你叔叔,黛博拉是你姑姑”——这种古怪的童话生物才会用的表达,究竟是怎么来的?由于习语源自复杂的词源背景,人工智能想要理解它们简直比登天还难。好吧,我不再画蛇添足,暂且放下这些英式胡话。关键在于,编造习语并观察谷歌AI概览如何绞尽脑汁解读其含义,实在是件乐事(据Futurism报道)。

我们硬件团队对此乐此不疲。比如让谷歌AI解读“千万别把处理器放在GPU旁边烹饪”这句无厘头习语时,它至少给出了一个勇敢的尝试,通过解释硬件瓶颈现象来圆其说。

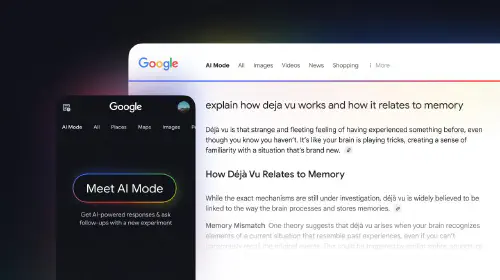

当我们的安迪询问AI时,它回答:“这个说法……用幽默方式强调CPU……和GPU……性能不匹配的危害,尤其在游戏中。暗示若用弱CPU搭配强GPU(反之亦然),较弱的组件会拖累整体性能,导致糟糕体验。”但当我刚刚提问时,它却说:“这个说法……幽默地警告不要用烤箱加热故障GPU来维修,这种‘烤箱疗法’可能融化焊点导致更严重损坏。”

老实交代:谁把“烤箱疗法”告诉了AI?虽然有人曾用这招拯救老旧GPU,但我必须强烈警告——就算不考虑保修,至少为你家的安全着想。

由于大语言模型只是预测最可能出现的下一个词,它会不加批判地解析所有信息。正因如此——加上它们对相同提示给出不同回答的倾向——基于LLM的AI往往不可靠,甚至作为参考工具也未必实用。最近就有独立开发者试图将类《毁灭战士》游戏塞进二维码,向三个AI聊天机器人求助存储方案,结果耗费两天近300次提示才获得有用建议。

谷歌AI概览几乎从不会反驳“这只是你编的”——不过我偶然发现有个表达显然让AI监管者犹豫了。当我询问“永远别让AI做人类的工作”时,直接被提示“此搜索无AI概览结果”。而我们的戴夫得到的解释却引用了《黑客帝国》里的史密斯探员,这里就不深究了。无论如何,参与优化AI输出的人类远比你以为的要多,谷歌AI概览拒绝配合的态度就是明证。

去年谷歌曾在博客表示,正着力遏制“不应显示AI概览的无意义查询”和“可能提供误导建议的用户生成内容”。我不死心,将搜索提示改为明确性别化的表述,AI概览称“男人的工作”特指“需要特定知识、技能或经验的任务,通常超出经验不足者的能力”。那么“女人的工作”呢?谷歌AI概览拒绝置评。