GitHub(代码托管平台)上的张吕敏(Lvmin Zhang)与斯坦福大学(Stanford University)的曼尼什·阿格拉瓦拉(Maneesh Agrawala)合作,本周发布了FramePack技术。该方案通过固定长度时序上下文实现高效视频扩散处理,可生成更长时长、更高质量的影片——基于FramePack架构构建的130亿参数模型仅需6GB显存即可生成60秒片段。

FramePack是一种采用多阶段优化技术的神经网络架构,支持本地化AI视频生成。目前其图形界面运行着定制化的“混元”(Hunyuan)底层模型,但研究论文指出,现有预训练模型均可通过该架构进行微调。

传统扩散模型需分析先前生成的含噪帧来预测下一帧的降噪结果,其参考的输入帧数量(即时序上下文长度)会随视频尺寸增长。标准视频扩散模型通常需要12GB以上显存,降低显存需求将导致生成片段缩短、画质下降及处理时间延长。

FramePack创新性地根据帧重要性将输入画面压缩至固定长度的上下文尺寸,大幅降低GPU内存占用。所有帧需压缩至预设的上下文长度上限,研究者称其计算成本与图像扩散模型相当。该技术还结合了防“画面漂移”(即视频质量随长度衰减)的解决方案,可在保证画质的前提下生成长视频。

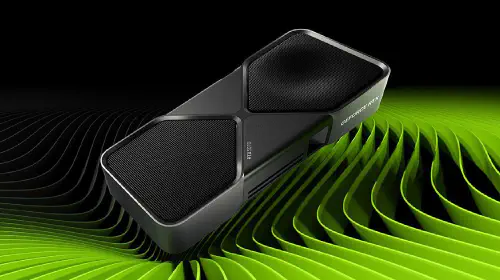

现阶段FramePack需配备支持FP16/BF16数据格式的RTX 30/40/50系列显卡(未验证图灵架构及更早型号,也未提及AMD/英特尔硬件的兼容性),支持Linux系统。除RTX 3050 4GB版本外,多数现代RTX显卡均可满足6GB显存需求。性能方面,RTX 4090配合teacache优化可达0.6帧/秒的生成速度,实际表现因显卡而异。系统会实时显示每帧生成结果。

当前模型可能存在30FPS的帧率限制,但其意义在于让普通用户无需依赖昂贵第三方服务即可体验AI视频生成。即使非内容创作者,也能将其作为制作GIF动图、表情包等趣味工具。